Populäre Methoden der erklärbaren KI (Explainable AI, kurz: XAI)

Yana Chekan

Es gibt viele Gründe, Erklärbarkeit in Ihr ML-Projekt zu integrieren (mehr dazu hier). Ebenso viele Möglichkeiten gibt es, diese umzusetzen. Dieser Beitrag ist der zweite in der XAI-Reihe von dida. Darin werden wir uns mit den unterschiedlichen Ontologien befassen, die in der XAI-Literatur zu finden sind, um einen Überblick über die beliebtesten Methoden zur Erklärbarkeit zu geben.

Die Frage, wie genau Machine-Learning-Modelle, insbesondere so große wie LLMs, Aufgaben so gut lösen können, für die sie nie trainiert wurden, bleibt in der ML-Community eine nicht gelöste Frage. Hier kommt die XAI-Forschung ins Spiel, um einen Blick in die Black Box zu werfen.

Ontologien

Auch außerhalb des ML-Bereichs besteht der erste Schritt zur Erklärung einer Sache darin, Fragen zu stellen. Die erste Frage, die wir uns stellen könnten, lautet: „Was wissen wir über ein bestimmtes Modell?“ Wenn Sie Ihr erstes NN mit ein oder zwei versteckten Schichten auf dem MNIST-Datensatz trainiert haben und herausfinden möchten, warum „1“ oft mit „7“ verwechselt wird. Ein Blick auf die Trainings- und Testdatensätze könnte als Erklärung ausreichen: Das Modell hat möglicherweise mehr Beispiele für die eine als für die andere Zahl gesehen, oder die Beispiele im Trainingsdatensatz enthalten nur sehr ähnliche Darstellungen der beiden Zahlen. Wenn Sie hingegen ein einfaches Perceptron-NN trainiert haben, kennen Sie wahrscheinlich die gesamte Mathematik hinter Ihrem Projekt und können zu Recht behaupten, dass Sie genau wissen, wie das Modell funktioniert. Wie die Autoren einer berühmten SHAP-Methode in ihrer Arbeit feststellen: „Die beste Erklärung für ein einfaches Modell ist das Modell selbst.“ Diese Beispiele zeigen eine Möglichkeit, die Erklärbarkeitsmethoden zu unterscheiden: in Ansätze zur Datendarstellung und zur Datenverarbeitung.

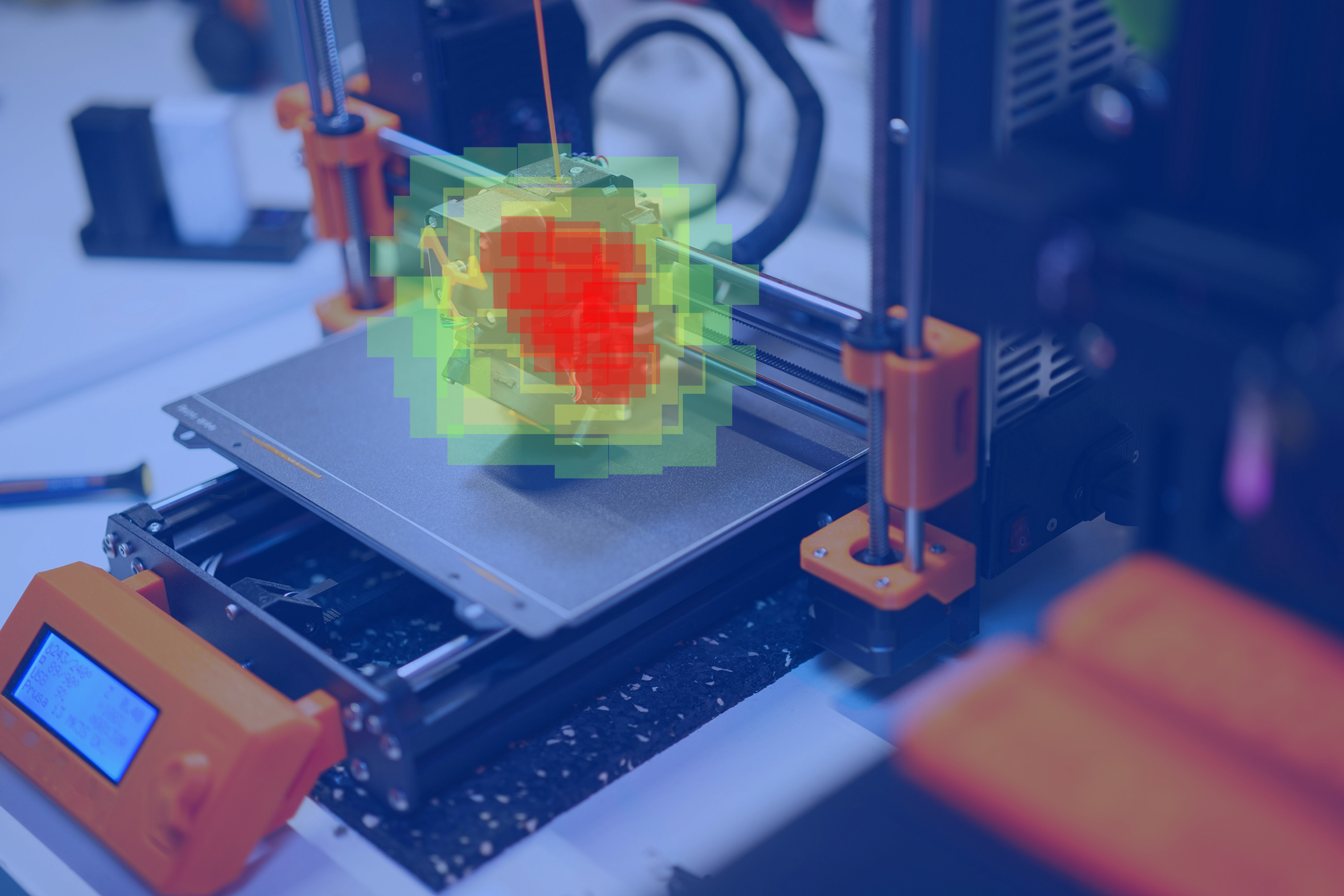

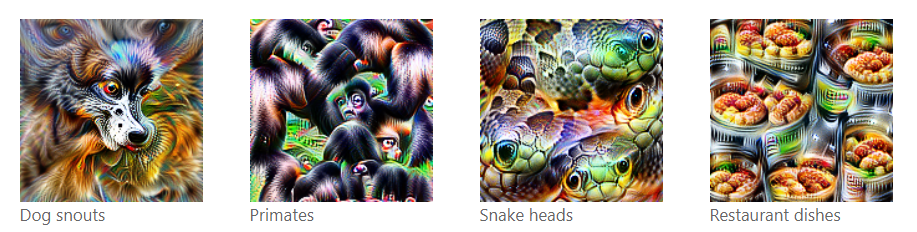

Eine sehr interessante Methode aus der Gruppe der Datenverarbeitungserklärungen möchte ich unbedingt erwähnen: das Projekt „Feature Visualization“. Olah et al. fanden Wege, Eingaben zu generieren, die die Aktivierung in den Neuronen verschiedener Schichten eines InceptionV1-Netzwerks maximierten, und zeigten so beispielsweise, was das Modell als Hund „versteht“. Unten sehen Sie einen Screenshot von der Website des Projekts.

Was ich bisher beschrieben habe, bezieht sich eher auf den Forschungsbereich, der sich mit dem Verständnis von KI im Allgemeinen befasst. Diese Erklärungen würden jedoch einen Kunden aus der Industrie oder jemanden ohne die erforderlichen Grundkenntnisse wahrscheinlich nicht zufriedenstellen. Eine Nutzergruppe, für die dies besonders gilt, sind Ärzte: Sie benötigen Erklärungen, um eine hilfreiche und nicht nur behauptende Unterstützung zu erhalten und um den Patienten eine informierte Einwilligung zur KI-Verarbeitung ihrer Daten zu ermöglichen (die nur dann informiert ist, wenn sie wissen, wie das Modell funktioniert).

Eine weitere sinnvolle Frage, die man sich bei der Entscheidung für die eine oder andere Erklärbarkeitstechnik stellen sollte, lautet: „Was möchten wir erklären?“. Wenn die Antwort lautet: „Wir möchten die inneren Abläufe des Modells erklären“, sollte man nach einer globalen Erklärungsmethode suchen. Wenn hingegen die Motivation hinter bestimmten Modellergebnissen für unseren Anwendungsfall interessanter ist, wäre eine lokale Erklärungsmethode besser geeignet. Das oben beschriebene Projekt „Feature Visualization“ ist eine globale Erklärungsmethode, da es versucht zu erklären, wie einzelne Teile eines Netzwerks die Welt wahrnehmen.

Es gibt viele konkrete Möglichkeiten, Erklärungen zu implementieren, aber die Forschungsgemeinschaft ist sich über die Nützlichkeit von Salienz-Mapping und kontrafaktischen Erklärungen einig. Es handelt sich um leicht verständliche Methoden, die auf ähnliche Weise funktionieren und am besten am Beispiel eines Bildklassifizierungsmodells verstanden werden können. Eine Salienz-Mapping-Methode würde etwas Ähnliches wie eine Heatmap der Aufmerksamkeit des Modells ausgeben und die Bereiche hervorheben, die für die Entscheidung des Modells am wichtigsten waren. Kontrafaktische Erklärungen dienen ebenfalls dazu, die wichtigsten Teile einer Eingabe zu finden, tun dies jedoch, indem sie minimale Teile davon finden, die, wenn sie auch nur geringfügig verändert würden, zu einer anderen Modellentscheidung führen würden. Denken Sie an ein Modell, das Vögel identifizieren kann: Ein Gimpel wäre kein Gimpel mehr, wenn er keinen roten Bauch hätte. Betrachten Sie nun einen Buchfink, der ebenfalls eine rote Brust hat, aber eine blaue Krone auf dem Kopf. Der Schwerpunkt einer Salienz-Karten-Erklärung für die Entscheidung zugunsten eines Gimpels würde auf dem roten Bauch und dem schwarzen Kopf des Vogels liegen (und auf dem schneebedeckten Hintergrund oder den Ebereschenbeeren, wenn Sie mit Ihren Trainingsdaten nicht sehr sorgfältig umgehen). Eine kontrafaktische Erklärung würde sich ebenfalls auf diese Bereiche konzentrieren, aber das Modell würde seine Entscheidung dadurch begründen, dass es das veränderte Eingabebild mit der blauen Kopf-Farbe des Gimpels visualisiert, um zu zeigen, dass dies die minimale Veränderung ist, die erforderlich ist, um seine Entscheidung zugunsten des Buchfinken zu ändern. Diese beiden Methoden gehören zur Gruppe der lokalen Erklärungen.

Nicht alle Modelle sind hinsichtlich ihrer Erklärbarkeit gleich: Einige sind von Natur aus besser interpretierbar, wenn ihre Struktur eine direkte Überprüfung der Beiträge der Eingabemerkmale zur Ausgabe ermöglicht (wie lineare Regression oder flache Entscheidungsbäume), andere weniger - oft aufgrund ihrer Komplexität und nichtlinearen Merkmalsinteraktionen (DNNs, SVMs).

Wenn die Komplexität des Modells die Anwendung bestehender Erklärbarkeitsmethoden nicht zulässt oder wenn das Modell nicht mit einer integrierten Erklärbarkeitsfunktion entwickelt wurde, können aus ihnen Ersatzmodelle (oft auch als Proxy-Modelle bezeichnet) abgeleitet werden, die das Verhalten des Originalmodells imitieren und gleichzeitig ein gewisses Maß an Erklärbarkeit ermöglichen, wodurch Einblicke in den Fokus des Originalmodells gewonnen werden können. Viele Salienzmethoden sind Ersatzmethoden.

Methoden

Nachdem wir nun die Klassifizierungsgrundlage der Methoden behandelt haben, können wir einige der Methoden im Hinblick darauf betrachten.

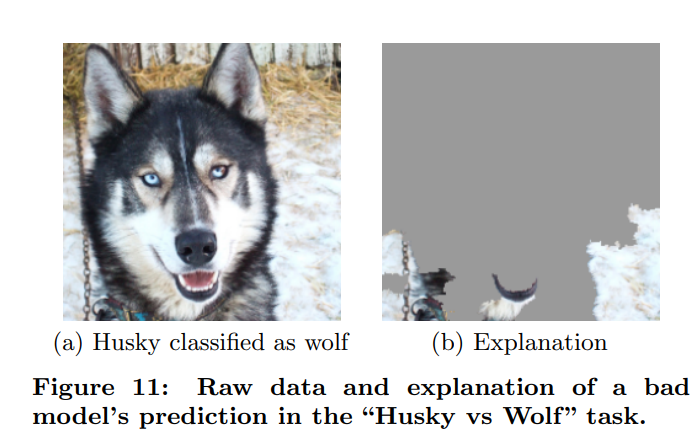

LIME

Eine der bekanntesten Techniken zur Erklärbarkeit ist Local Interpretable Model-Agnostic Explanations (LIME), die ein Black-Box-System und eine Instanz von Interesse als Eingabe nimmt und das erstere erklärt, indem sie das Verhalten bei Störungen einer ausgewählten Eingabe untersucht. Die resultierenden Daten werden verwendet, um ein lokales Modell zu erstellen (im Wesentlichen zu trainieren), das als Stellvertreter für das ursprüngliche Modell in der Umgebung der ausgewählten Eingabe dient. Mit anderen Worten: Das Ausgabemodell simuliert das Verhalten des ursprünglichen Modells, ist jedoch eine einfachere Version davon, sodass die Zuordnung der Merkmalsbedeutung leichter erfasst werden kann. Auf diese Weise können Sie nicht nur die Bereiche der Eingabe identifizieren, die für die Entscheidung am einflussreichsten sind, sondern diese auch auf verschiedene Problemdomänen und verschiedene ML-Modelle anwenden. In derselben Veröffentlichung, in der LIME vorgestellt wurde, wurde eine Fallstudie durchgeführt, um diese Methode in der Praxis zu demonstrieren. Ribeiro et al. verwendeten LIME, um einen voreingenommenen Klassifikator zu erklären, der häufig Huskys mit Wölfen verwechselte. Sie fanden heraus, dass der einflussreichste Bereich der Eingabe für die Entscheidung des Modells „Wolf” der verschneite Hintergrund war.

LIME ist von Natur aus eine lokale Methode zur Ersatzdatenverarbeitung. Es gibt jedoch bereits Arbeiten, die auf LIME aufbauen und eine globale k-LIME-Methode vorschlagen, bei der ein Clustering-Algorithmus auf das Black-Box-Modell angewendet wird, um k Cluster zu finden und für jeden von ihnen ein verallgemeinertes lineares Modell zu lernen, um die Vorhersagen eines Modells nachzuahmen, das es erklärt.

LRP

Layer-Wise Relevance Propagation ist eine Methode zur Merkmalszuordnung, die zur Gruppe der Salienzmethoden für lokale Erklärungen gehört. Das Ziel dieser Methode ist es, den Beitrag jedes einzelnen Merkmals zur Vorhersage zu quantifizieren. Sie eignet sich für verschiedene Eingabemodalitäten wie Bilder, Videos und Text. LRP propagiert die Vorhersage f(x) - beispielsweise ein generiertes Wort oder Token - mithilfe speziell entwickelter Propagierungsregeln, die je nach Schichttyp angepasst werden können, rückwärts durch das neuronale Netzwerk.

AttnLRP

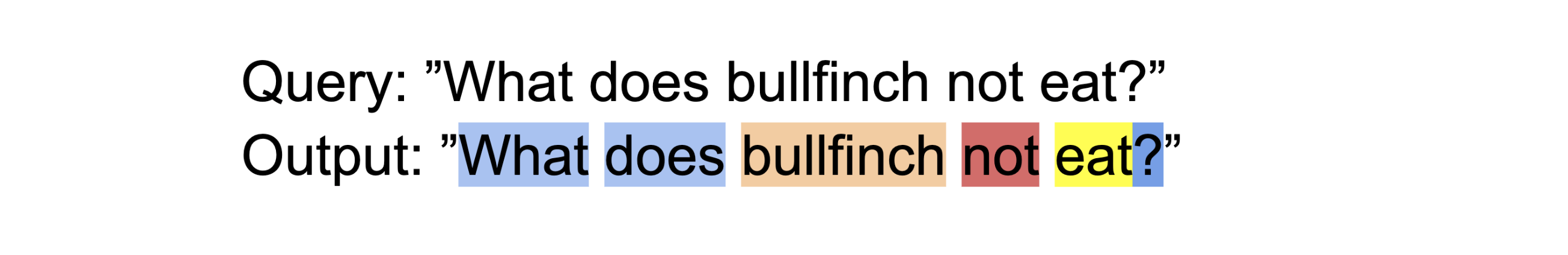

Eine Erweiterung von LRP, AttnLRP, ist in der Lage, das oben Genannte mit Transformer-Modellen zu tun und dabei gleichzeitig den Rechenaufwand zu minimieren.

Ein Modell, das AttnLRP verwendet, könnte seine Aufmerksamkeit wie folgt verteilen:

AttntLRP würde dem Partikel „nicht“ eine sehr hohe Relevanz zuweisen, da die Negation oft die gesamte Semantik des Satzes verändert. „Gimpel“ ist von großer Bedeutung, da es sich um das gesuchte Objekt handelt, während das Verb nur mäßig beiträgt. LRP-Methoden funktionieren nicht nur mit Benutzeranfragen, sondern können auch verwendet werden, um die Modellantwort in ihrer Wissensdatenbank zu verankern und dem Benutzer die Quellen anzugeben, aus denen die Informationen extrahiert wurden.

SHAP

SHapley Additive Explanations funktionieren ähnlich wie LRP und LIME, verwenden jedoch den spieltheoretischen Ansatz, um das übergeordnete Ziel zu erreichen. Tatsächlich beginnt die Veröffentlichung, in der SHAP vorgestellt wird, damit, dass gezeigt wird, wie LRP, LIME und Classic Shapley Values dasselbe Erklärungsmodell (d. h. jede interpretierbare Annäherung an das ursprüngliche Modell) namens „Additive Feature Attribution Method” verwenden. Die Quantifizierung der Zuordnung jedes Merkmals zum Ergebnis scheint daher eine sehr aufschlussreiche Erklärung zu sein, die auf vielfältige Weise umgesetzt werden kann.

Der Unterschied zwischen SHAP und den früheren Methoden liegt in der Art und Weise, wie die Merkmalszuordnungen geschätzt werden: Shapley-Werte (das zugrunde liegende spieltheoretische Konzept) werden ermittelt, indem jedes Merkmal als Spieler in einem Spiel zur Maximierung des Gewinns betrachtet und der individuelle Beitrag jedes Spielers zur Vorhersage gemessen wird. Die Werte werden berechnet, indem alle möglichen Spielerkombinationen - Koalitionen - und das Ergebnis, das sie gemeinsam erzielen würden, berücksichtigt werden.

SHAP verfolgt diesen Ansatz und schlägt eine Methode zur Annäherung an diese Werte vor, da die Berücksichtigung aller Merkmalskombinationen in einem ML-Modell rechnerisch sehr aufwendig (wenn nicht gar unmöglich) sein kann.

Es handelt sich um eine modellunabhängige lokale Methode, was bedeutet, dass sie alle Arten von Modellen erklären kann, sogar Transformer.

CounTEX

Die Methode der kontrafaktischen Erklärung mit Text-gesteuerten Konzepten ist weit weniger bekannt als LIME oder LRP, aber wir wollten ein konkretes Beispiel aus der Familie der kontrafaktischen Erklärungen geben und dieses ist interessant, weil die Autoren einen Algorithmus trainiert haben, der natürliche Sprache verwendet, um die visuelle Erklärung zu untermauern. Diese Funktion hilft zu erklären, welcher Teil des hervorgehobenen Bereichs in der kontrafaktischen Erklärung wichtig war, ob es das Muster oder die Farbe war, die für die Entscheidung wichtig war. Dies kann hilfreich sein, wenn sich die kontrafaktische Erklärung in einem sehr kleinen Bereich des Eingabebildes befindet und ein Mensch nicht genau sagen kann, was ihm als Erklärung gezeigt wird.

Fazit

Erklärbarkeit ist ein wichtiger Bestandteil der ML-Forschung, da sie dazu beiträgt, eine Wissensbasis aufzubauen, auf der das Vertrauen der Nutzer aufgebaut werden kann und die die Akzeptanz algorithmischer Entscheidungsfindung auch in sensibleren Arbeitsbereichen fördern kann. Es gibt noch keinen Industriestandard für Erklärbarkeit, aber das bedeutet nur, dass jeder eine Methodenkategorie wählen kann, die seinen Bedürfnissen am besten entspricht.

Dieser Text stellt einige wichtige Erklärbarkeitsmethoden vor und zeigt auf, wie diese Methoden klassifiziert werden können. Durch die Einführung verschiedener Kategorien soll ein Überblick über die Forschungsrichtungen im Bereich der Erklärbarkeit gegeben werden, und es werden konkrete Beispiele für jede Kategorie genannt.