Datenerfassung

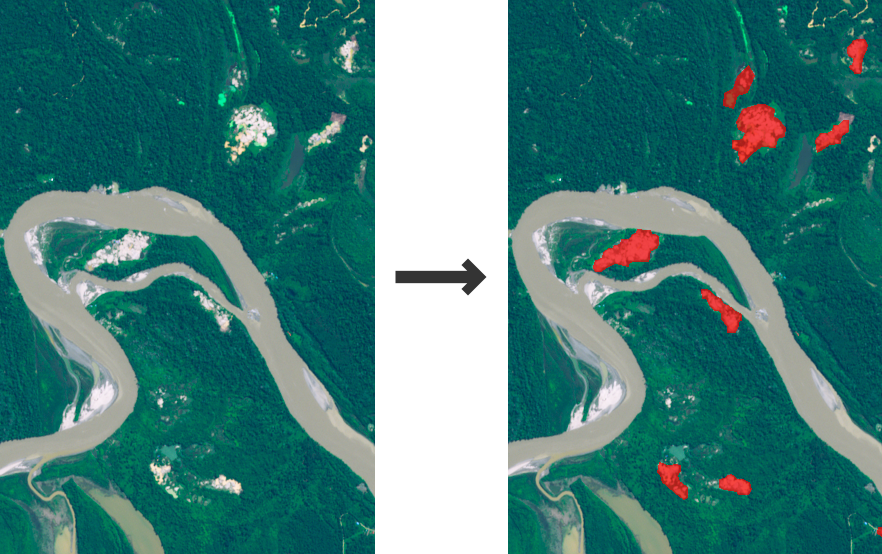

Unser Partner bei MRE kennzeichnete etwa 100 Planet Scope Bilder. Bei diesem Projekt war ein einziger Bergbauexperte für die Kennzeichnung zuständig. Für den Prototyp beschränkten wir die AOI auf den Nordosten von Surinam. Dieses Gebiet wurde ausgewählt, weil es repräsentativ für viele Regionen ist, in denen ASM-Standorte zu finden sind. Die Region liegt im Amazonas-Regenwald, und der hydraulische Bergbau ist die vorherrschende Methode für den Goldabbau. Planet Scope war die primäre Satellitenkonstellation, da sie eine der höchsten verfügbaren Auflösungen bietet (ca. 5m/px). Sentinel-2 wurde ebenfalls erfolgreich getestet, war jedoch nicht der primäre Fokus dieser Studie.

Das Labelling erfolgte mit LabelBox. Das Labelling erfolgte nicht auf dem RGB-Bild (also im Bereich der sichtbaren Wellenlängen), sondern auf einer Graustufendarstellung des normalisierten Wasser-Differenz-Indexes (NDWI). PlanetScope hat vier Kanäle (RGB+NIR). Der NDWI wird berechnet als

$$NDWI = \frac{G - NIR}{G + NIR}$$

und hebt Bereiche mit hohem Wassergehalt hervor. Der NDWI wird den PlanetScope Bildern als fünfter Kanal beigefügt. Der normalisierte Vegetations-Differenz-index (NDVI) wird berechnet als

$$NDVI = \frac{NIR - R}{NIR + R}$$

und hebt die Vegetation in den Bildern hervor. Er wird als sechster Kanal an die Eingabedaten angehängt.

Verwendete Technologien

Backend: Python, PyTorch, Numpy, Matplotlib, Requests, geopandas, rasterio, geojson, Sentinelsat

Infrastruktur: GCloud (Training + storage), Git, DVC